Expertenbeitrag von Christoph Hein im Business Intelligence Magazin, Oktober 2018

Überlebensfrage.

Erfolgreiche Unternehmen brauchen eine gut organisierte «Information Supply Chain». Eine aktuelle Studie zeigt die Gestaltungsmöglichkeiten auf – und die oft gefährlichen Lücken in vielen Organisationen.

Vor einigen tausend Jahren wurde der Steinzeitmensch vom Jäger und Sammler zum Bauern. Die neolithische Revolution, die bislang größte Umwälzung der Menschheitsgeschichte, legte den Grundstein für unsere heutige Zivilisation. Sie bildete die Basis für unsere Arbeitsteilung und damit den gesamten technologischen Fortschritt der Menschheit.

Aktuell befinden sich Unternehmen an einem durchaus vergleichbaren Scheideweg: und zwar in Bezug auf ihr Informationsmanagement, einem zentralen Wertschöpfer der heutigen Wirtschaft. Genau wie damals die Menschen in der Steinzeit, müssen sich die heutigen Organisationen grundsätzlich entscheiden, ob sie weiter den ausgetretenen Pfaden folgen oder eine neue Art der Versorgung wagen wollen.

Denn gegenwärtig erfolgen das Datenmanagement und die darauf fußenden Analysen nach dem bereits erwähnten Modell des Jägers und Sammlers: Es wird lediglich geprüft, welche Daten vorhanden sind, um dann die am einfachsten verfügbaren für Analysen zu nutzen.

Diese allzu simple Vorgehensweise hat einige Nachteile – ähnlich wie die der Jäger und Sammler, die unter einseitiger Ernährung litten, von externen Faktoren wie etwa den Wanderungen des Wilds abhängig waren und in der Nahrungsbeschaffung fortlaufend einen hohen personellen Aufwand betreiben mussten. Die aktuelle Informationsbeschaffung in den Unternehmen hat vor allem drei Nachteile:

– Erstens sind die zugänglichsten Daten nicht automatisch die besten

– Zweitens können sich die Datenquellen hinsichtlich des Inhalts und der Struktur verändern oder versiegen

– Drittens bindet ein hoher manueller Aufwand im Datenmanagement wichtige Ressourcen.

Unvoreingenommene Analysen.

Die allgemein als sehr praktisch empfundene Tatsache, dass größere Datenmengen heutzutage immer einfacher verfügbar sind, birgt für Unternehmen die Gefahr, in die sogenannte «Semantische Falle» («Semantic Trap») zu tappen.

Dieser Begriff aus der Theorie zur «Information Supply Chain» beschreibt das grundsätzliche Problem, dass Daten nur die Informationen liefern können, die sich aus ihnen ableiten lassen. Oder einfach gesagt: Was ich nicht messe, kann ich nicht auswerten. Werden zum Beispiel bei der Kontierung eines Bewirtungsbelegs nur die Summe und das Datum erfasst, sind weitere spätere Analysen des Datensatzes beispielsweise unter den Gesichtspunkten der Uhrzeit, des Orts oder einzelner Positionen technisch nicht mehr möglich.

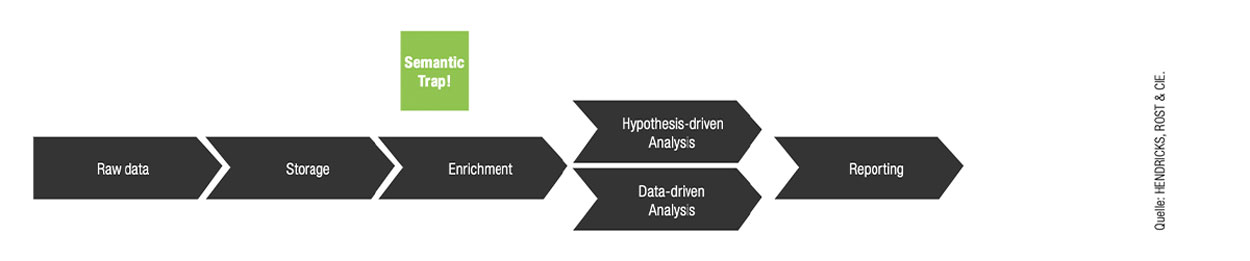

Im Prozess der «Information Supply Chain», wie er in der Abbildung unten dargestellt ist, befindet sich die «Semantische Falle» am Übergang vom ersten Schritt der Ermittlung der Rohdaten («raw data») zum zweiten, der dauerhaften und nachhaltigen Speicherung der Daten («storage»). An dieser Stelle werden die Merkmale zur dauerhaften Speicherung aus den Rohdaten ermittelt. Die restlichen Eigenschaften aber werden nicht vorgehalten und stehen für etwaige künftige Analysen nicht mehr zur Verfügung. Mit diesem Manko verbunden besteht das Risiko eines nur sehr eingeschränkten Erkenntnisgewinns.

Das Modell «Information Supply Chain».

In der Informationsversorgungskette müssen die zu messenden Daten genau definiert werden, sonst ergeben die Auswertungen keinen Sinn. Denn am Übergang vom ersten Schritt (Erstellung der Rohdaten) zum zweiten (Speicherung) lauert eine «Semantische Falle».

Dieses Problem ist an und für sich nicht neu, gewinnt aber mit der zunehmenden Datenmenge an Brisanz. So können beispielsweise die im Millisekundentakt erfassten Sensordaten der Maschinen in den «Smart Factories» nicht dauerhaft in dieser Granularität gespeichert werden. Sie müssen komprimiert werden. Im Rahmen dieser Verdichtung können allerdings – bedingt durch die «Semantic Trap» – für eine zukünftige Analyse wichtige Merkmale verlorengehen.

Eine gesunde Mischung.

Das gleiche Grundproblem stellt sich bei der Auswahl der Rohdaten, etwa in der Produktion oder im Vertrieb, die zur Ableitung weiterer Merkmale verwendet werden: Wenn sich ein Unternehmen immer auf die am einfachsten und zugänglichsten Daten konzentriert, entsteht ein eingeschränktes Abbild der Realität, welches später nicht mehr verifiziert oder falsifiziert werden kann.

Das kann in der Praxis fatale Folgen mit sich bringen. Beispiel: In den meisten Unternehmen werden zwei getrennte Systeme für die Produktion und den Wareneingang verwendet. Aus beiden lässt sich der Materialverbrauch für die Produktion ableiten. Wird für die Auswertung nur eines der beiden Systeme verwendet, kann die gesamte Wertschöpfungskette nur unzureichend analysiert werden.

Ein Fokus auf das Produktionssystem hat dann zur Folge, dass Verluste im Lager (beispielsweise aufgrund unsachgemäßer Lagerung oder Diebstahls) nicht registriert werden. Konzentriert sich das Management hingegen einseitig auf das Wareneingangs- oder auch Lagerungssystem, können übermäßige Verbräuche bei einzelnen Maschinen tendenziell nicht erkannt werden.

Welche Gefahren diesbezüglich in der Praxis bestehen, zeigt eine Studie von HENDRICKS, ROST & CIE. und der Hochschule Heilbronn: Die befragten Unternehmen richten den Fokus nach wie vor stärker auf die unternehmensinternen Daten und erhalten so wahrscheinlich nur ein eingeschränktes Bild der Realität.

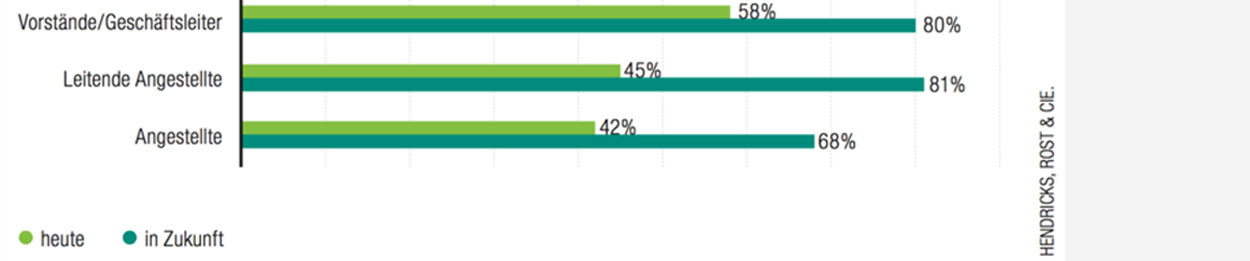

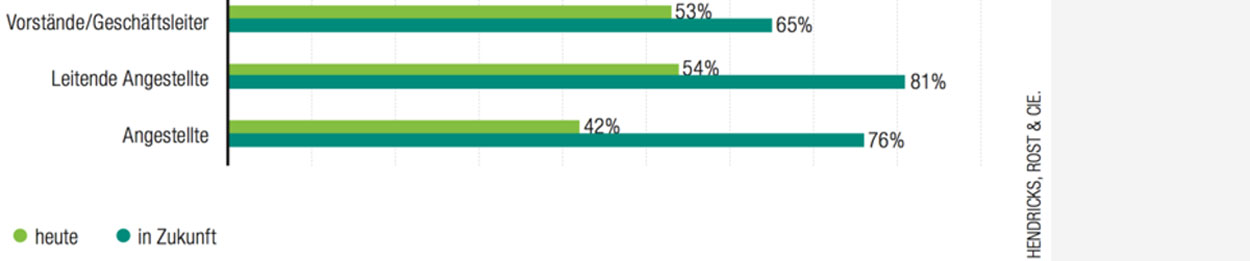

Allerdings sind das Topmanagement und leitende Angestellte bereits heute der Meinung, dass das Datenmanagement für die Erlangung von Wettbewerbsvorteilen eine deutliche strategische Relevanz hat. Für die Zukunft teilen sogar mehr als 80 Prozent der Studienteilnehmer diese Einschätzung.

Wettbewerbsvorteile im Blick.

Vorstände und Geschäftsführer werten das Datenmanagement – mehr als leitende Angestellte und sehr viel stärker als andere Angestellte – in seiner Bedeutung für das Erreichen von Wettbewerbsvorteilen als «hoch» oder «sehr hoch».

Ganz wie bei unseren Vorfahren kommt es also auf die gesunde Mischung aus verschiedenen Quellen an, um so einer einseitigen Zufuhr – wie heutzutage üblich – vorzubeugen. Auch wenn es aufgrund des Überangebots an Informationen so scheint, als wäre es unerheblich, welche Rohdaten für die Analysen verwendet werden – die Mischung macht den entscheidenden Unterschied aus.

Informationsvielfalt: In der Datenwelt von Unternehmen genauso vorhanden wie in der Tierwelt dieser uralten Felsmalereien von Buschmännern in Namibia.

Externe Einflüsse.

Betrachten die Entscheidungsträger in der Organisation die Daten als betriebswirtschaftlichen Rohstoff, dann ist das Verständnis für die Tatsache sehr viel stärker, dass Informationsquellen genauso wie etwa Nahrung oder Heizmaterial mit der Zeit versiegen oder nicht mehr in der gewünschten Qualität da sein können.

Daraus folgen für Unternehmen zwei Handlungsimperative: Zum einen müssen sie sich fortlaufend um die Erschließung neuer Datenquellen bemühen und so den Verlust bestehender Informationsbestände kompensieren. Zum anderen müssen sie sich um die nachhaltige Pflege der bestehenden Datenreservoire kümmern.

Ersteres kann sich zum Beispiel durch einen Systemwechsel im Unternehmen ergeben, wenn etwa das Kundenmanagementsystem in einer Abteilung durch ein Produkt eines anderen Herstellers ersetzt wird, das bestimmte Auswertungen auf Kundenebene im Gegensatz zum vorherigen System nicht mehr ermöglicht. Da diese Auswertungen aber weiterhin benötigt werden, muss sich das Management um eine neue Bezugsquelle kümmern.

Der zweite Punkt betrifft beispielsweise Marktdaten, die von externen Dienstleistern bezogen werden. Die Kategorien, nach denen diese Daten gruppiert werden, wie etwa die Einteilung in Branchen oder in Unternehmensgrößen, können sich ändern. Es kann auch passieren, dass die Berechnungsweise der gelieferten Kennzahlen plötzlich umgestellt und daher auch der Marktanteil des eigenen Unternehmens anders ausgewiesen wird.

Wie die Studie zeigt, sind viele Unternehmen nicht dafür gerüstet, derartige Fehlinformationen erkennen zu können. Denn sie konzentrieren sich größtenteils auf die unternehmensinternen Daten als Grundlagen für das Management.

Die wichtige vertikale Integration von Kundendaten in die eigenen Prozesse ist jedoch laut der Untersuchung nur bei jedem zweiten Unternehmen gegeben; Lieferanten- und Wettbewerbsdaten aus der gleichen Branche verwendet nur jede vierte Organisation. Und der Analyse von Informationen aus anderen Branchen – also dem wichtigen Blick über den Tellerrand – widmen sich sogar nur fünf Prozent der befragten Studienteilnehmer.

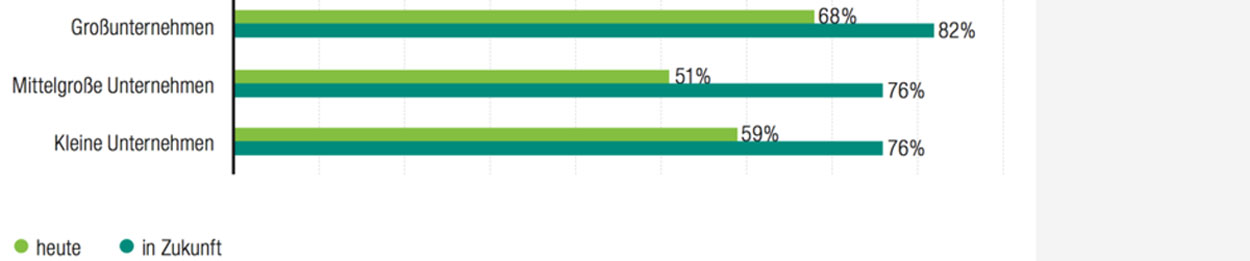

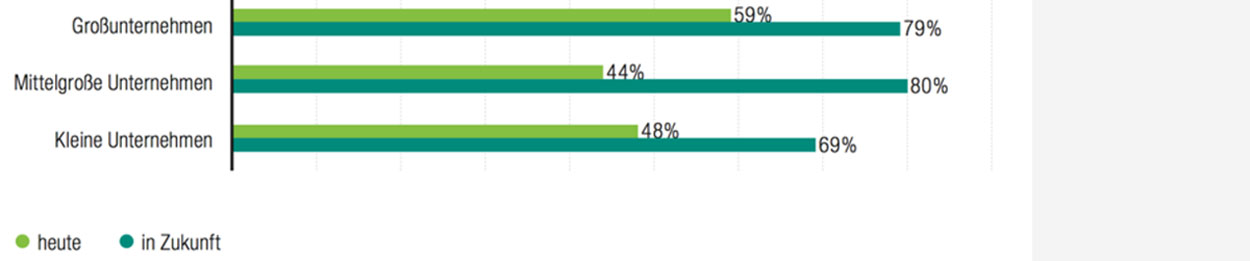

Zwei Drittel der großen Unternehmen mit einem Jahresumsatz von mehr als 500 Millionen Euro sehen die Relevanz zur Unterstützung der gesamten Fachprozesse durch ein Datenmanagement bereits heute als hoch oder sogar sehr hoch an. Bei mittelgroßen Unternehmen mit einem Jahresumsatz von 100 bis 500 Millionen Euro sind es nur die Hälfte; ein knappes Drittel der Teilnehmer aus dieser Größenklasse schätzt die heutige Relevanz sogar nur als niedrig oder sehr niedrig ein.

Genau dieser Blick über den Tellerrand indes ist für die Zukunftsfähigkeit von Unternehmen von zentraler Bedeutung. Denn es ist sicher, dass sie sich vor allem aufgrund der stetig steigenden Datenmengen und der anstehenden Integration weiterer externer Datenquellen mit großen Herausforderungen konfrontiert sehen. Datengetriebene Analysen können – sofern für die Algorithmen eben jene Daten zur Verfügung stehen – zusätzliche Potentiale für neue Geschäftsfelder aufzeigen, die sich nicht automatisch aus den eigenen Daten ableiten lassen.

Solche Daten werden beispielsweise benötigt, um neue Märkte für etwaige innovative Produkte zu analysieren. Wenn ein Spezialunternehmen wie etwa Vorwerk sich dazu entschließt, neben Staubsaugern künftig auch Küchenmaschinen und dann Teekocher zu verkaufen, ist es elementar, dass es vorher möglichst viele Informationen aus diesen neuen Branchen eingehend studiert und verarbeitet.

Auch hier verhält es sich prinzipiell in heutigen Unternehmen wie bei unseren Vorfahren in der Steinzeit: So wie diese sich fortlaufend auf die Suche nach neuen Jagdgebieten machen mussten, um die Nahrungsversorgung der Gruppe sicherzustellen, so sollten auch Unternehmen heute kontinuierlich an der Versorgung mit frischen, nützlichen Daten arbeiten.

Diesem Erfordernis steht ein Hindernis im Weg. In den meisten Unternehmen ist das Datenmanagement auch heute noch echte Handarbeit. Prozesse müssen per Knopfdruck angestoßen und Daten manuell validiert werden. Darunter leidet nicht nur die Datenqualität; es werden auch wichtige Ressourcen gebunden, die anderweitig produktiver eingesetzt werden könnten.

Chancen der Automatisierung.

Auf zur Automatisierung all dieser Arbeiten? Dies kann nur der Anfang auf dem Weg zu einer voll ausgebildeten «Data-driven Company» sein. Denn in einer solchen werden sämtliche Schritte automatisiert sein: zum einen, um die Ressourcen für höherwertige Tätigkeiten verfügbar zu machen und zum anderen, um durch eine automatische Datenvalidierung und eventuell daraus abgeleitete Korrelationen wirklich neue Erkenntnisse zu gewinnen.

So wird zum Beispiel während der Einführung eines Business Intelligence-Systems zumeist viel Wert auf die Automatisierung der ETL-Prozesse gelegt. Aber die Validierung der eingespeisten Daten erfolgt mit hohem, manuellem Aufwand. In der Regel werden die Werte aus dem BI-System händisch mit den Daten im SAP-System verglichen.

Prozessunterstützung mit Perspektive.

Große Unternehmen sehen es in Bezug auf die heutige Situation als wichtiger an, die gesamten Fachprozesse durch Datenmanagement zu unterstützen, als kleine und vor allem mittlere. Hinsichtlich des künftigen Bedarfs gleichen sich die Einschätzungen an.

Besser ist es hingegen, wenn sich das Management von vornherein geeignete Maßnahmen zur automatischen Datenvalidierung überlegt und diese entsprechend implementiert.

Wenn diese Maßnahmen ausbleiben, kann im Unternehmen einiges schiefgehen: Denn nach den Anpassungen im System müssen die Validierungen in der Regel erneut erfolgen und dabei können sich Fehler einschleichen. Dabei könnte dieser Prozess durch eine Automatisierung zu einem Großteil entfallen.

Eine derartig automatisierte Entscheidungsfindung aber wird, wie die Studie zeigt, bei mehr als 90 Prozent der Teilnehmer weder auf operativer noch strategischer Ebene umgesetzt.

Dennoch sehen die Angestellten unter den Befragten für die Zukunft ein hohes bis sehr hohes Kostensenkungspotential durch ein entsprechendes Datenmanagement – deutlich mehr als innerhalb des Topmanagements. Eventuell drückt sich hierin die Angst vor der aktuell noch nicht forcierten Automatisierung aus.

Abwartend bei Kostenreduktion.

Leitende Angestellte erwarten eher als die Topetage, dass das Datenmanagement dabei helfen kann, die Kosten zu senken. Einfache Mitarbeiter sind in Bezug auf die Gegenwart zurückhaltend, glauben aber an eine stärkere Unterstützung in der Zukunft.

Dabei bietet die Automatisierung von Entscheidungsprozessen oft Potentiale: Freigabeprozesse können auf der Basis fest definierter Kriterien durch den Computer erfolgen, und der Mensch wird nur noch in strittigen Situationen hinzugezogen. Die Banken zum Beispiel praktizieren dieses Verfahren schon länger auf dem Gebiet der «Fraud Detection» bei Finanztransaktionen sehr erfolgreich.

Aber auch Prozesse des Qualitätsmanagements lassen sich durch die Automatisierung optimieren. Und auf der strategischen Ebene kann sie bei der Bereinigung des Produktportfolios anhand definierter Kennzahlen/Kriterien eingesetzt werden; oder vollautomatisch sogar auf der Basis von «Unsupervised Learning» – einem Verfahren maschinellen Lernens, bei dem vorab weder die Zielwerte noch die spätere Reaktion des Umfelds beispielsweise vom Markt oder in der Politik bekannt sind. Die Software versucht, anhand der Ähnlichkeiten der Eingabedaten neue Muster zu erkennen, die sie automatisch clustert.

Diese Möglichkeiten, die menschliche Arbeitskraft durch akkurat funktionierende Maschinen zu ersetzen, sind ein ähnlicher Entwicklungssprung wie es die Entstehung der Landwirtschaft in der Steinzeit war, als Arbeitskräfte freigesetzt wurden und die Produktivität extrem anstieg. Und die Arbeitsteilung zwischen Mensch und Maschine eröffnet immer wieder neue Perspektiven: In Zeiten des Fachkräftemangels können beispielsweise durch gezielte Automatisierungsmaßnahmen wertvolle Mitarbeiter für höherwertige Tätigkeiten eingesetzt werden.

Stabsstelle für Datenstrategien.

Sicherlich bringen viele Unternehmen in einzelnen Bereichen der IT ständig Innovationsprojekte auf den Weg. Allerdings kommen die meisten beim Datenmanagement nicht über singuläre Leuchtturmprojekte hinaus: Unterschiedliche Abteilungen verfolgen ihre eigenen Strategien und Initiativen, und eine Abstimmung erfolgt wenig bis gar nicht.

Insbesondere im Bereich der Hype-Themen, wie etwa Big Data oder «Machine Learning», werden in den unterschiedlichen Abteilungen der Organisationen Initiativen gestartet. Das Problem dabei ist, dass diese Projekte nur mit einem auf die Erfordernisse der jeweiligen Abteilung eingeschränkten Zielkorridor angegangen werden, ohne das gesamte Unternehmen in den Blick zu nehmen.

Ergebnis: Die IT- und die Finanzbereiche betreiben jeweils ein eigenes Projekt mit dem gleichen Subjekt, ohne voneinander zu wissen. So entsteht Sand im Unternehmensgetriebe und erzeugt eine Unmenge an doppelter Arbeit.

Die Studie bestätigt diese Beobachtungen. So stellte sich heraus, dass nur etwa 20 Prozent der Unternehmen eine übergreifende Stabsstelle betreiben, die sich mit dem Thema Datenmanagement beschäftigt. Überwiegend wird dieses Gebiet entweder von der IT-Abteilung betreut, welcher in der Regel der fachliche Background fehlt, um Themen umfassend zu verstehen, oder von den einzelnen Fachabteilungen (meist Finanzen und Controlling), bei denen es zumeist an technischem Know-how und an organisatorischen Berechtigungen für eine optimale und schnelle Umsetzung mangelt.

Allerdings sehen beispielsweise unter den Teilnehmern aus dem Mittelstand heute auch nur etwas mehr als 40 Prozent eine hohe oder sehr hohe Relevanz einer beschleunigten Reaktionsfähigkeit auf Kundenwünsche, egal ob intern oder extern. In Zukunft hingegen halten das doppelt so viele Befragte für wichtig.

Skepsis bei Reaktionszeiten.

Nur rund die Hälfte der befragten Unternehmen sieht in der aktuellen Lage die Möglichkeit, mittels Datenmanagement schneller auf Kundenwünsche reagieren zu können. Für die Zukunft ist die große Mehrheit diesbezüglich allerdings optimistischer.

Diese Potentiale sollten Topmanager jetzt frühzeitig nutzen. Denn eine kohärente und übergreifende Strategie für ein Datenmanagement bietet Unternehmen die Chance, alle Initiativen und Projekte zu dem Thema zu kanalisieren und Kompetenzen zu bündeln. Es bietet sich an, eine entsprechende Stabsstelle zu schaffen, die über entsprechende Kompetenzen hinsichtlich der Technologie, der fachlichen Anforderungen und Organisation verfügen muss.

Die Aufgabe dieser Stabsstelle in der Organisation müsste unter anderem sein, die möglichst objektive Aufbereitung der Daten zur Vermeidung semantischer Fallen zu überwachen sowie die Pflege bestehender und die proaktive Erschließung neuer Datenquellen zu übernehmen. Dabei sollte sie sich möglichst nicht in operativen, vorwiegend manuell ausgeführten Tätigkeiten verlieren.

Eine Überlebensentscheidung.

Sicherlich gab es auch in der Steinzeit einzelne Gruppierungen, die sich der neolithischen Revolution verschlossen haben und an ihren bestehenden Arbeitsweisen, wie beispielsweise der personalintensiven Jagd, festgehalten haben. Diese Stämme existieren auch heute noch in einigen unzugänglichen Gebieten der Erde. Aber die Landwirtschaft und die daran gekoppelte Arbeitsteilung haben sich als die dominante Strategie erwiesen.

Natürlich können sich Unternehmen gegen den Weg einer «Data-driven Company» entscheiden und an ihren bewährten Arbeitsweisen festhalten. Überleben aber dürften auch sie dann nur, weil der Rest der Welt sie in ihrer Nische existieren lässt.

Professor Dr. Wanja Wellbrock ist Inhaber einer Professur für Beschaffungswirtschaft an der Hochschule Heilbronn. Seine primären Forschungsgebiete sind Supply Chain Management, strategisches Beschaffungsmanagement und Big Data Anwendungen in unternehmensübergreifenden Wertschöpfungsketten.

Christoph Hein ist Berater und «Data Nerd» bei dem Düsseldorfer Consultingunternehmen HENDRICKS ROST & CIE. Er beschäftigt sich seit vielen Jahren intensiv mit dem Datenmanagement in Unternehmen – unter anderem mit Themen wie Industrie 4.0 oder Big Data, Predictive oder Prescriptive Analytics.

Quelle: BUSINESS INTELLIGENCE MAGAZINE, www.bi-magazine.net

© ProfilePublishing Germany GmbH Oktober 2018. Alle Rechte vorbehalten.